文本是《使用指南(共68篇)》专题的第 12 篇。阅读本文前,建议先阅读前面的文章:

- 1.使用 一步 API 中转站怎样实现 OpenAI Function Call ?这篇教程告诉你

- 2.一步API调用主流大模型Claude/GPT/DeepSeek/Gemini/Grok最简单教程

- 3.一步API:批量生成知识图谱的高效解决方案

- 4.一步 API 批量生成产品包装设计:成本直降 85%,效率飙升 30 倍的设计新方案

- 5.一步 API 生成人物头像插画:低成本、高效率的创意设计方案

- 6.使用一步 API批量生成教学课件插图:高效创作指南

- 7.使用一步 API 批量创作 NFT 数字艺术:低成本、高效率的创作新路径

- 8.使用一步 API批量制作涂色本:低成本、高效率的创作方案

- 9.解锁 Cursor:一步 API 突破模型限制秘籍

- 10.一步 API 配置 Chatbox 全流程详细指南

- 11.必须海外信用卡?封号?告别繁琐!一步 API 轻松搞定 Claude 接入及常见问题

关键洞察

- 开创性范式: GPT-1确立了“生成式预训练”范式,通过大规模无监督数据学习通用语言模式,为后续大型语言模型的发展奠定了基石。

- 规模效应与零样本能力: GPT-2通过模型和数据集的巨大扩展,首次展现了“零样本学习”的惊人潜力,其“太强不敢公开”事件更是引发了社会对AI伦理的深刻反思。

- API商业化与少样本学习: GPT-3以1750亿参数刷新了模型规模纪录,并通过API开放,极大降低了大型AI模型的应用门槛,催生了如GitHub Copilot等革命性应用,并验证了“少样本学习”的强大效力。

- 人类对齐与ChatGPT基石: GPT-3.5(InstructGPT)引入的“人类反馈强化学习(RLHF)”技术,有效解决了模型与人类意图对齐的关键问题,成为ChatGPT取得空前成功的核心秘诀。

- 迈向多模态统一: GPT-4开启了模型的图像理解能力,而GPT-4o则实现了文本、语音、图像原生统一的多模态处理,大幅提升了模型的实时交互性与拟人化程度,预示着AI向更自然、更全面的感知与交互发展。

- 竞争格局与AI Agents未来: 尽管OpenAI领先,但Google Gemini、Anthropic Claude、Meta LLaMA等强劲对手正通过各自的创新策略(如原生多模态、安全对齐、开源)展开激烈竞争。未来AI将向更具自主性、能规划并执行复杂任务的“AI智能体(Agents)”方向演进。

概述

亲爱的探险家们,准备好踏上一场关于人工智能最前沿的激动人心之旅了吗?今天,我们将深入剖析OpenAI GPT系列模型的演进史,这不仅仅是一段技术发展的时间线,更是一部充满“哇”时刻和颠覆性突破的史诗!从GPT-1的蹒跚学步到GPT-4o的多才多艺,OpenAI如同一个不知疲倦的炼金术士,不断将海量数据和计算力熔炼成智慧的火花。我们将一同见证,这些模型如何从简单的“预测下一个词”成长为能够理解、生成、甚至创造的多模态智能体,它们不仅改变了我们与数字世界的互动方式,更深刻地影响着科学、商业乃至我们对智能本身的认知。

这次旅程将带我们穿梭于技术的里程碑之间,揭示每个GPT版本背后的核心奥秘:它们是如何被构建的?它们在哪些方面取得了突破?又带来了哪些深远的影响?更重要的是,我们将探讨这些AI巨兽在现实世界中的应用,以及它们在安全、伦理和未来发展方向上所面临的挑战与机遇。系好安全带,因为前方是充满发现和思考的奇妙旅程!

详细分析

在这里给大家推荐一个可以使用GPT-3.5 的网站,注册即送体验 https://yibuapi.com,

GPT模型早期发展与关键技术演进 (GPT-1, GPT-2, GPT-3, GPT-3.5)

大型语言模型(LLMs)的崛起并非一蹴而就,它如同生物演化般,在每一次迭代中不断积累和突破。OpenAI的GPT系列便是这场演化中的璀璨明星。

GPT-1 (生成式预训练 Transformer 1)

想象一下,你有一大堆未经整理的零散知识,如何才能从中提炼出智慧?GPT-1给出了一个优雅的答案——生成式预训练。2018年6月,OpenAI发布了GPT-1,它像是为大型语言模型铺设了一条金光大道。

GPT-1拥有一颗“不大不小”的心脏,1.17亿(117M)参数,采用的是12层仅解码器(decoder-only)的Transformer架构。它的训练数据主要来自包含7000多本未出版小说的BookCorpus,总计4.5GB文本,约10亿词汇,这让模型在预训练阶段就学会了如何理解长距离的上下文依赖。

其核心创新在于“半监督”的学习方法:

- 无监督预训练: 在海量无标签文本上“自由学习”,就像孩子通过大量阅读学会语言的模式和规律。

- 有监督微调: 接着,针对具体任务(如文本分类、问答),用少量带标签的数据进行“精修”,使其能在特定领域表现出色。

这种预训练-微调的范式,彻底改变了自然语言处理(NLP)领域的游戏规则,让模型能在标注数据稀缺的情况下,依然取得优异表现。

GPT-2 (生成式预训练 Transformer 2)

如果说GPT-1是AI的启蒙者,那么GPT-2就是那个突然展现出惊人天赋的“神童”。2019年2月,GPT-2部分面世,同年11月才全面公开。它的参数量跃升至15亿(1.5B),是GPT-1的十倍有余!

GPT-2沿用了GPT-1的单向Transformer架构,但通过规模的扩大和一些精巧的结构改进(如层归一化位置调整),它的能力发生了质的飞跃。训练数据也升级了,除了Common Crawl,更引入了WebText——一个包含800万篇文章、总计约40GB的“高质量”网页文本集合。

GPT-2最令人称道的是它的“零样本”(Zero-shot)能力。这意味着什么?就是你无需专门训练,只需通过简单的自然语言指令,模型就能直接完成翻译、摘要、问答等各种任务。例如,你给它一个指令:“翻译英文到中文:‘Hello world’”,它就能给出“你好,世界”。这简直像魔法一样!

然而,正是这份“魔法”引发了一场轩然大波——“太强不敢公开”事件。OpenAI最初担心GPT-2强大的文本生成能力(尤其是生成虚假新闻或恶意内容)可能被滥用,因此拒绝立即发布完整模型。这一举动,瞬间引爆了全球对AI伦理、安全和模型发布策略的讨论。它让我们开始思考:当AI的能力超越人类的控制时,我们该如何应对?最终,在审慎评估后,OpenAI才逐步公开了完整模型,此事件也成为了AI发展史上一个标志性的警钟。

GPT-3 (生成式预训练 Transformer 3)

2020年6月,GPT-3的横空出世,彻底震撼了世界。它的参数量飙升至令人咋舌的1750亿(175B)!这是当时最大的非稀疏语言模型,比GPT-2又大了100多倍,宛如一位拥有百科全书般知识的巨人。

GPT-3在架构上与GPT-2类似,但在规模上进行了显著扩展,并巧妙地引入了稀疏自注意力(sparse attention),这使得模型能高效处理高达2048个token的上下文窗口。它在更庞大、更多样化的数据集上进行训练,包括Common Crawl (60%)、WebText2 (22%)、Books (16%)和Wikipedia (3%),数据量高达数千亿个token。

GPT-3的核心突破是其无与伦比的“少样本”(Few-shot)和“零样本”(Zero-shot)学习能力。这意味着,你只需要给它极少的例子,甚至不给例子,它就能理解你的意图并完成任务,而无需进行耗时耗力的微调。这就像一个学习能力极强的人,看几眼就能掌握新技能。

更具里程碑意义的是,OpenAI选择了通过API(应用程序编程接口)的形式商业化开放GPT-3。这一策略彻底改变了大型AI模型的应用格局,极大地降低了开发者和企业使用LLM的门槛。一时间,基于GPT-3 API的应用如雨后春笋般涌现,其中最著名的莫过于GitHub Copilot——一个能根据你的注释或部分代码自动补全代码的AI编程助手。它展示了LLM在代码生成领域的巨大潜力,效率提升令人惊叹!

GPT-3.5 (InstructGPT)

如果说前面的GPT模型是“知识渊博”的,那么GPT-3.5系列(特别是其中的InstructGPT)则像是学会了“察言观色”,真正理解了人类意图的“智慧精灵”。2022年初,InstructGPT发布,而基于GPT-3.5模型家族的ChatGPT则在2022年11月引爆全球。

GPT-3.5的核心秘诀在于引入了革命性的人类反馈强化学习(Reinforcement Learning from Human Feedback, RLHF)技术。这项技术使得模型不仅能生成流畅的文本,更能生成符合人类偏好、有用、真实且无害的输出。

RLHF的工作原理,就像是教会一个AI如何成为一个“好学生”:

- 收集人类偏好数据: 让一群“老师”(人类标注员)评价模型生成的多个答案,并进行排序,告诉模型哪个答案更好。

- 训练奖励模型(RM): 利用这些人类偏好数据,训练一个独立的“评价专家”(奖励模型),它能给模型的每一个回答打分,分数越高代表人类越喜欢。

- 强化学习微调: 把这个“评价专家”作为AI的“教练”,让AI通过不断尝试和优化,生成能获得“教练”高分的回答。这就像训练一只狗狗,做对了就给奖励,让它学会正确的行为。

RLHF解决了传统语言模型可能出现的“幻觉”(生成不真实信息)、偏见或不符合用户意图的问题。它让模型从“预测下一个词”的概率机器,蜕变为一个能理解并执行复杂指令的“智能对话伙伴”。可以说,RLHF正是ChatGPT能够提供连贯、有用、安全对话体验的基石,也是其迅速风靡全球的决定性因素。

| 特性 | GPT-1 (2018) | GPT-2 (2019) | GPT-3 (2020) | GPT-3.5 (InstructGPT) (2022) |

|---|---|---|---|---|

| 参数量 | 1.17亿 | 15亿 | 1750亿 | 系列模型,参数量不等(如1.3B) |

| 核心创新 | 生成式预训练(预训练-微调) | 零样本能力;规模效应 | 少样本/零样本学习;API商业化 | RLHF(人类反馈强化学习) |

| 训练数据集 | BookCorpus | WebText | Common Crawl, WebText2等 | GPT-3数据+人类反馈数据 |

| 标志性事件 | N/A | “太强不敢公开”事件 | GitHub Copilot等应用涌现 | ChatGPT的基石 |

| 上下文窗口 | 较短 | 较短 | 2048 tokens | 更长,结合RLHF优化 |

在这里给大家推荐一个可以使用GPT-4, GPT-4-turbo, GPT-4o 的网站,注册即送体验 https://yibuapi.com,

GPT模型现代多模态时代深入剖析 (GPT-4, GPT-4-turbo, GPT-4o)

随着人工智能的飞速发展,模型不再满足于仅仅处理文本。它们开始渴望感知世界,像人类一样通过多模态(文本、图像、语音、视频)来理解和互动。OpenAI的GPT-4及其后续版本,正引领我们进入这个激动人心的多模态新时代。

GPT-4

2023年3月,OpenAI发布了GPT-4,这不仅仅是一个更强大的语言模型,更是一个重要的里程碑——它首次引入了图像输入能力!

GPT-4被设计成一个大型多模态模型,这意味着它不仅能像前代一样处理和生成文本,还能理解图像内容,并根据图像和文本的混合输入来生成文本输出。例如,你可以给它一张图片,并提问“这张图片里有什么?”或者“根据这张图,请写一段描述”,它就能给出准确的文字回答。虽然最初图像输入功能还在研究预览阶段,但其潜力已经令人惊叹。

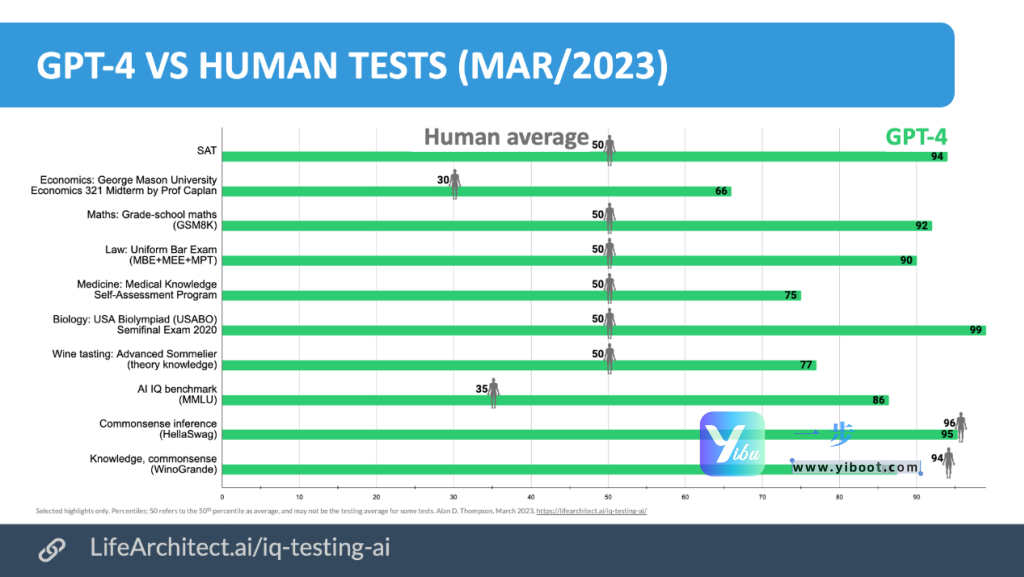

在推理与理解能力上,GPT-4相比前代有了显著提升。它在许多专业和学术基准测试中表现出超越人类的水平:

- 在律师资格考试中,GPT-4的得分超越了90%的人类考生,而GPT-3.5仅在倒数10%。

- 在生物学奥林匹克竞赛中,它也位列前1%。

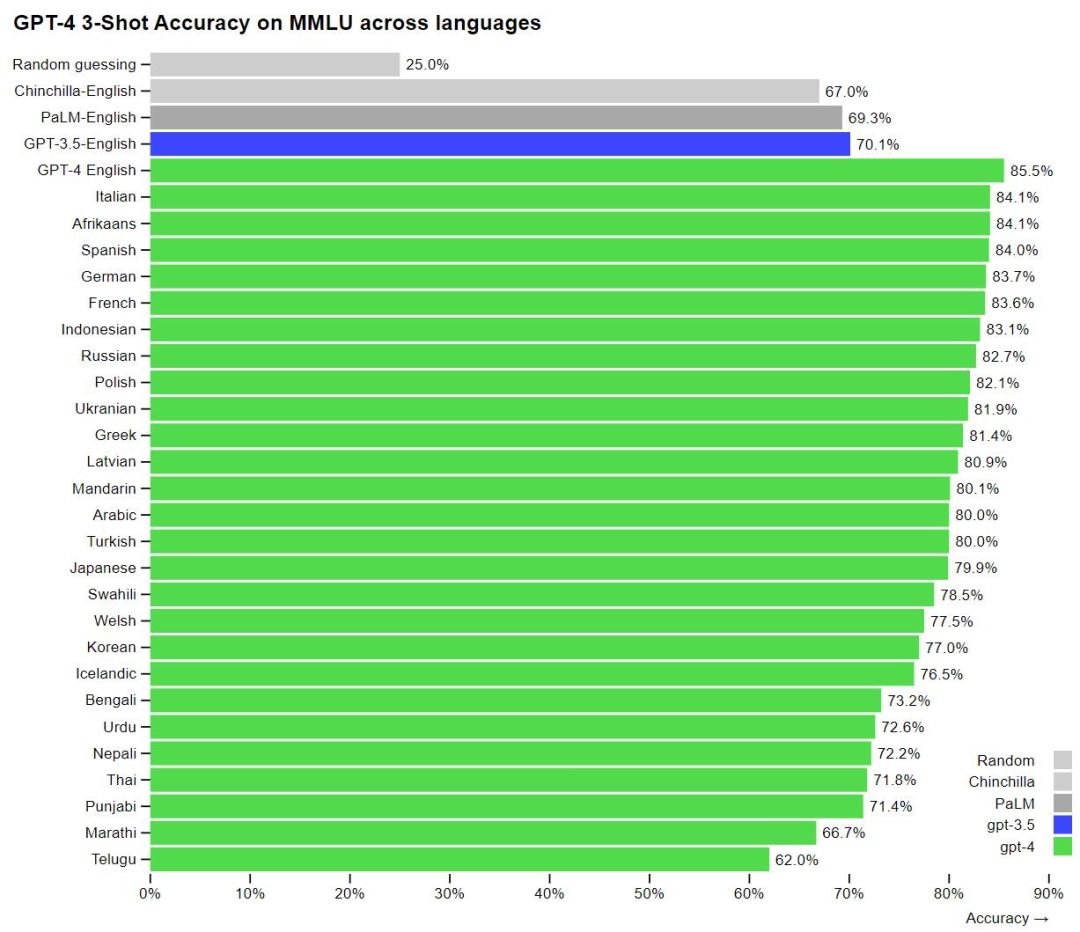

- 在MMLU(大规模多任务语言理解)基准测试中,GPT-4的表现也明显优于其他大型模型。

图示:MMLU基准测试中,GPT-4(绿色)的表现明显优于GPT-3.5(蓝色)及其他语言模型。

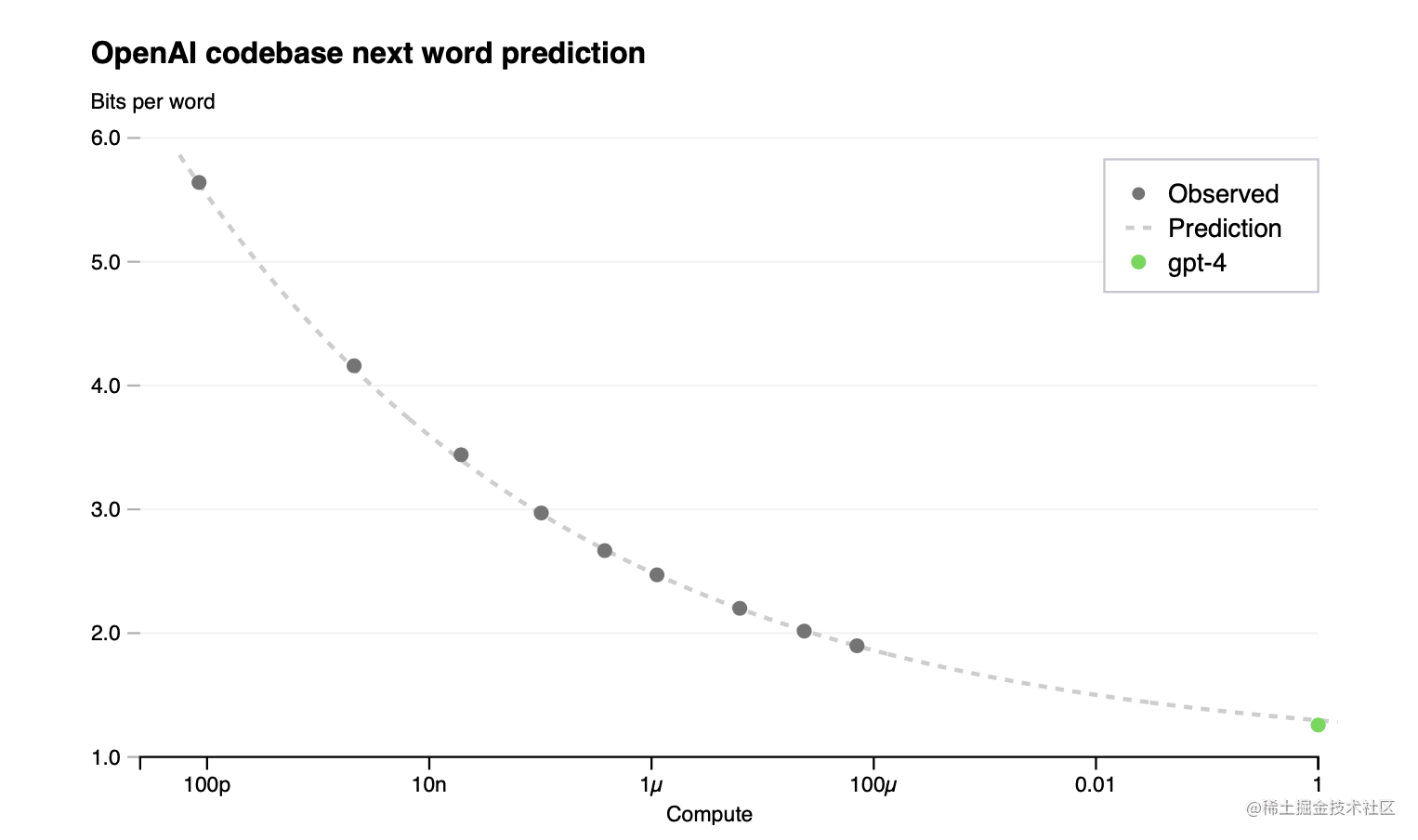

OpenAI虽然没有公开GPT-4的具体参数量和架构细节,但普遍分析和泄露信息表明,GPT-4很可能采用了混合专家模型(Mixture of Experts, MoE)架构。这是一种巧妙的设计,它允许模型拥有万亿级的庞大参数,但在实际运行中,每次只激活其中一部分“专家”网络来处理任务。这就像是一个巨大的智囊团,每次只派出最擅长某个领域的专家来解决问题。MoE架构的优势在于,它能在不牺牲性能的前提下,大幅减少计算量和内存需求,从而提高训练效率和推理速度。

图示:混合专家模型(MoE)架构被认为可以提升GPT-4在多模态任务中的效率,尤其在处理大型数据集和基准测试时。

GPT-4还支持8k和32k的上下文长度,相较于GPT-3.5有了显著提升,使得模型能够处理更长的文本输入,进行更深层次的对话和分析。

图示:GPT-4在多项标准化测试中的表现,如律师资格考试(Bar Exam)、生物奥赛(Biology Olympiad)等,均超越了人类平均水平。

GPT-4 Turbo

2023年11月发布的GPT-4 Turbo,可以看作是GPT-4的“增强版”。它在GPT-4的基础上进行了多项优化,尤其是上下文窗口和成本效率方面。

GPT-4 Turbo将上下文处理能力提升到了惊人的128k tokens,这意味着它能够一次性理解和处理大约300页的文本内容!这对于需要分析长篇文档(如法律文件、研究论文)或进行长时间连贯对话的应用来说,无疑是巨大的福音。实现如此大的上下文窗口,需要克服巨大的计算和内存挑战,但它为更复杂、更全面的AI应用打开了大门。

同时,GPT-4 Turbo在成本上更加亲民,输入token的价格约为GPT-4的一半,输出token的价格也更低,这使得它在实际应用中更具经济效益。

GPT-4o (Omni)

而到了2024年5月,OpenAI发布了令人振奋的GPT-4o(“o”代表“omni”,即“全能”),这是一款划时代的原生多模态统一模型!它彻底改变了我们对AI交互的想象。

GPT-4o最显著的特点是它能作为单个神经网络原生处理文本、语音和图像的输入与输出。这意味着什么?以前,你可能需要用一个模型识别语音,再用另一个模型理解文本,最后再用第三个模型生成图像。现在,GPT-4o将所有这些能力整合到一个“大脑”中,实现了不同模态间的深度融合,大幅降低了响应延迟和部署复杂度。

想象一下:你对着手机说话,GPT-4o能以近乎人类的响应速度(低至320毫秒,人类对话平均约210毫秒)实时回复你,而且它的声音可能充满情感,还能识别你的情绪!在演示中,GPT-4o展现了在英语和西班牙语之间进行实时语音翻译的能力,并支持50多种语言。

更令人惊叹的是,GPT-4o还具备情感识别能力。它能处理完整的音频输入,并将其中的情绪、语调纳入其输出生成,从而实现更具情商的对话。它还能连接到实时摄像头,描述你看到的内容,甚至能独立生成图像,而不再需要调用外部DALL-E 3模型。这无疑是向未来具身智能迈出的重要一步!

此外,GPT-4o在token化效率方面也有所提升,特别是对于中文、印地语和阿拉伯语等非罗马语言,这意味着这些语言的用户将享受到更低的成本。

GPT模型现代多模态对比一览表

| 特性 | GPT-4 (2023年3月) | GPT-4 Turbo (2023年11月) | GPT-4o (Omni) (2024年5月) |

|---|---|---|---|

| 多模态能力 | 接受图像和文本输入,生成文本输出 | 接受图像和文本输入,生成文本输出 | 原生统一处理文本、语音、图像输入与输出 |

| 上下文长度 | 8k/32k tokens | 128k tokens | 128k tokens |

| 模型架构 | 推测MoE架构(1.8T参数,8x220B专家) | MoE架构延续 | 统一多模态Transformer架构 |

| 响应速度 | 相对较慢 | 较GPT-4更快 | 显著提升,实时音频对话延迟低至320ms |

| 成本/效率 | 较高 | 较GPT-4更具成本效益 | 对非罗马语言token化效率更高,整体成本效益优化 |

| 核心应用场景 | 文本生成、摘要、问答、代码生成 | 更长的文档处理、复杂对话 | 实时语音交互、跨模态内容生成、情感识别、具身智能体 |

| 是否开源 | 否 | 否 | 否 |

GPT生态应用、未来挑战与行业格局研究

大型语言模型(LLM)的浪潮,如同科技界的巨浪,不仅卷起了技术革新,更深远地改变了各行各业的生态。OpenAI的GPT系列,正是这场变革的核心驱动力。

1. GPT模型在各领域的具体应用案例

GPT模型凭借其强大的理解和生成能力,在多个领域展现出惊人的应用潜力,并不断催生着创新。

- 文本生成与内容创作:这是GPT模型的“老本行”!从辅助撰写电子邮件、营销文案,到生成诗歌、剧本,GPT模型展现了惊人的创造力。例如,Jasper AI和Copy.ai等工具利用GPT技术,帮助内容创作者以惊人的速度生成高质量文案。用户普遍反映,这些工具能将内容创作效率提升数倍,极大地解放了人力。

- 代码辅助与软件开发:你是否梦想过拥有一个“AI搭档”帮你写代码?GitHub Copilot就是其中的佼佼者。它基于OpenAI Codex(GPT-3的衍生版本),能够根据你的注释或部分代码,自动补全、生成函数甚至测试用例。据GitHub内部研究显示,使用Copilot的开发者完成任务的速度平均加快了55%!这不仅仅是速度的提升,更是编程体验的革命,让开发者能更专注于解决核心问题。

- 教育领域:AI正在悄然改变学习方式。GPT模型能够提供个性化的学习内容、解答疑难问题,甚至充当语言学习伴侣。例如,Duolingo Max就将GPT-4整合到其语言学习应用中,提供个性化的语法解释和角色扮演练习,让学习变得更互动、更高效。

- 医疗健康领域:在医疗这样严谨的领域,GPT模型作为辅助工具展现了巨大潜力。它可以快速阅读和总结海量医学文献,帮助医生获取最新研究进展,甚至为初步诊断提供辅助建议。有研究表明,GPT-4在USMLE(美国执业医师资格考试)上取得了优异成绩,这表明其在医学知识掌握方面达到了令人瞩目的水平。当然,AI在医疗领域的应用必须强调,它们是医生的“得力助手”,而非替代品,最终诊断仍需专业医生的判断。

- 法律领域:面对浩瀚的法律条文和案例,GPT模型能够辅助律师起草合同、分析法律文件,甚至快速检索和分析海量判例。它能帮助律师从繁琐的案头工作中解放出来,将更多精力投入到策略制定和案件分析上。但同样,法律的严谨性要求AI的输出必须经过专业人士的严格审查。

2. AI对齐、安全与伦理挑战及解决方案

正如任何强大的技术一样,GPT模型在带来巨大便利的同时,也带来了前所未有的挑战。如何确保AI的行为符合人类的意图、价值观和道德标准,即AI对齐(Alignment),成为了摆在OpenAI和整个AI社区面前的首要任务。

挑战是什么?

- “幻觉”与误导信息: 模型可能生成听起来像真的一样,但实际上是错误或虚假的信息。

- 偏见与歧视: 训练数据中可能存在历史偏见,模型在学习后可能会放大这些偏见,导致不公平的输出。

- 滥用风险: AI可能被用于生成虚假新闻、深度伪造(deepfakes)、网络钓鱼诈骗,甚至恶意代码。

- 隐私泄露: 模型在学习过程中可能无意中“记住”并泄露敏感的个人信息。

OpenAI及业界的解决方案与框架:

- 人类反馈强化学习(RLHF): 正如我们前面提到的,这是解决对齐问题的核心技术。通过人类的“投票”和“打分”,教会模型什么是“好”的输出,什么是“不好”的输出,从而让模型行为更符合人类偏好。

- Constitutional AI(宪法AI): 这是Anthropic公司提出的一种创新方法。它不依赖大量人工标注,而是通过一系列预设的“宪法原则”(如“避免偏见”、“诚实”、“无害”)来指导AI自我纠正其生成的内容,使其在没有人为干预的情况下也能更好地遵循伦理规范。

- 模型红队(Red Teaming): OpenAI及其他机构会组建专门的“红队”,他们的任务就是像“黑客”一样,尝试找出模型的安全漏洞和潜在的滥用方式。通过这种对抗性测试,发现模型的薄弱环节,并进行针对性改进。

- 负责任AI原则与治理: 许多科技巨头和政府机构都发布了负责任AI的指导原则,强调公平性、可解释性、隐私性、安全性、透明度等。欧盟的《人工智能法案》更是全球首部全面规范AI的法律框架,旨在确保AI的安全和可控。

- API访问控制与内容审核: OpenAI通过严格的API使用政策和内容审核机制,限制GPT模型被用于非法或有害的目的。

3. 主要竞争对手分析

尽管OpenAI凭借GPT系列长期领跑,但AI领域的竞争从未停止。全球的科技巨头和创新公司都在大力投入,形成了一个多元且充满活力的竞争格局。

| 竞争对手 | 旗舰模型 | 技术特点 | 市场策略 |

|---|---|---|---|

| Google Gemini 系列 | Gemini Ultra, Gemini Pro, Gemini Nano | 原生多模态,无缝处理文本、图像、音视频;长上下文窗口(Gemini 1.5 Pro 达100万token);MoE架构。 | 深度集成到Google产品(搜索、Workspace);通过Vertex AI提供企业服务;强调负责任AI。 |

| Anthropic Claude 系列 | Claude 3 Opus, Sonnet, Haiku | 强调安全性与对齐(Constitutional AI);推理、编码、多语言能力强;支持200K+上下文。 | 专注于企业级应用,满足高安全伦理要求的客户;由OpenAI前员工创立。 |

| Meta LLaMA 系列 | LLaMA 2, LLaMA 3 | 开源模型,推动技术普及和创新;性能优异,与闭源模型竞争。 | 赋能开发者社区,加速AI民主化;支持边缘部署和本地化。 |

| Mistral AI | Mistral 7B, Mixtral 8x7B (MoE) | 小而强大,高效高性能,适合边缘设备;稀疏专家混合(SMoE)架构。 | 兼顾开源与商业化(API服务、私有化部署);以成本效益和效率吸引企业。 |

OpenAI的地位:OpenAI凭借GPT系列在通用AI能力、用户体验和市场认知度上占据领先地位,尤其通过其API商业化策略,成功构建了“AI即服务”的模式。然而,面对竞争对手在原生多模态、伦理对齐和开源策略上的创新,OpenAI面临着持续的竞争压力。能否在保持领先的同时,兼顾模型的安全、效率和可访问性,将是其未来发展的关键。

4. 未来模型(如传闻中的GPT-5)和AI发展趋势(如AI Agents)

大型语言模型的未来充满了无限可能,我们正站在一个新时代的门槛上。

-

更强大的基础模型:

- GPT-5及后续模型:尽管官方尚未公布,但业界普遍预测,未来的GPT模型将继续在参数规模、训练数据和多模态能力上实现突破。传闻中的GPT-5有望在推理、逻辑、长上下文理解和减少“幻觉”方面有显著提升,甚至可能具备初步的通用人工智能(AGI)的雏形。

- 具身智能:AI模型将与物理世界更紧密地结合,通过机器人或虚拟代理与环境互动,执行复杂任务。

-

AI Agents(AI智能体)的崛起:

- 定义:想象一个AI,它不仅仅是回答问题,还能自主感知环境、制定计划、执行复杂的多步骤任务,甚至与外部工具互动并进行自我修正。这就是AI智能体(AI Agents)。它们不再仅仅是“工具”,而是具有一定自主性的“助手”。

- 核心能力:AI Agents将具备强大的规划(Planning)能力,将大任务拆解为小步骤;拥有记忆(Memory),能记住过往经验;具备工具使用(Tool Use)能力,调用搜索引擎、代码解释器等;还能进行反思(Reflection),评估自己的表现并学习改进。

- 发展趋势:AI Agents被视为实现通用人工智能的关键一步。它们将在自动化工作流、智能助理、个性化服务和复杂问题解决方面发挥巨大作用。例如,Auto-GPT等项目已经初步展示了AI Agents的潜力,它们能自主地完成从概念到执行的全过程。

-

多模态的深度融合:未来的AI模型将更加深入地融合文本、图像、音频、视频等多种模态,实现真正的跨模态理解和生成,让AI能够以更自然、更全面的方式与世界互动。

-

AI安全与对齐的持续投入:随着AI能力的增强,对AI安全、伦理和对齐的投入将变得前所未有的重要。这将是一个持续的、需要全球协作的努力,以确保AI的发展符合人类的福祉。

-

模型小型化与边缘部署:除了大型云端模型,轻量级、高效的模型将在手机、物联网设备等边缘设备上得到更广泛应用,实现低延迟和隐私保护,让AI无处不在。

调查手记

宏大图景:从“预训练”到“对齐”的AI进化论

GPT模型家族的发展,是一部激动人心的AI进化史诗。它从GPT-1的“生成式预训练”理念开始,确立了AI从海量数据中学习语言模式的范式,就像给AI打下了坚实的地基。GPT-2和GPT-3则展示了规模化带来的惊人力量,不仅让模型“博览群书”,更具备了在几乎没有任何额外训练下完成复杂任务的“零样本”和“少样本”能力。这种能力上的飞跃,如同让AI从“学霸”变成了“天才”。

然而,这场进化的高潮出现在GPT-3.5(InstructGPT)引入RLHF技术时。这不仅仅是技术参数的提升,更是AI发展理念上的一个质的飞跃——从单纯追求模型能力,转向了人类意图对齐。RLHF如同给AI装上了一个“道德罗盘”和“用户体验指南”,让它们学会如何成为真正“有用、无害、诚实”的AI。正是这一步,才让ChatGPT得以席卷全球,将大型语言模型从实验室带入千家万户,真正改变了我们与AI的交互方式。

真实世界应用:AI的千面人生

GPT系列模型不仅仅是冷冰冰的代码和数据,它们正在真实世界中扮演着越来越重要的角色:

- 代码世界的“副驾驶”:GitHub Copilot证明了AI可以成为人类程序员最得力的助手,让代码编写变得更加高效和充满乐趣。

- 创作者的“灵感缪斯”:AI写作工具正在帮助营销人员、作家甚至学生更快地生成高质量内容,让创意不再受限于时间和精力。

- 教育的“个性化导师”:从语言学习应用Duolingo Max,到提供定制化学习材料的平台,AI正让学习变得更具个性、更易获得。

- 专业领域的“智慧助手”:在医疗和法律这样高风险、高专业门槛的领域,GPT模型正悄然成为医生和律师的“信息分析师”和“研究员”,虽然它们不能取代人类专家的判断,但无疑是提升效率的强大工具。

这些应用展示了AI的巨大潜力,它们正在渗透到我们生活的方方面面,改变着工作的定义和知识的获取方式。

幕后故事:AI的伦理抉择与突破

在GPT模型的演进过程中,不乏引人深思的幕后故事。最著名的莫过于GPT-2发布时的“太强不敢公开”事件。OpenAI的内部担忧和最终的谨慎发布,如同给整个AI界敲响了警钟:当技术能力超越人类的掌控时,我们该如何负责任地部署它?这场讨论推动了AI伦理和安全研究的进步,也促使OpenAI后续在模型发布上更加审慎。

而RLHF技术的诞生,则是对模型“幻觉”和偏见问题的深层思考。如何让一个仅仅“预测下一个词”的AI,真正理解并遵循人类复杂的指令和价值观?RLHF通过引入人类的智慧反馈,巧妙地将强化学习的力量引导向“对齐”目标,这是一种技术与人文的完美结合。它证明了在AI发展中,人类的参与和反馈至关重要,而不是简单地追求“越大越好”。这些故事告诉我们,AI的发展不仅是技术的竞赛,更是对人类智慧、伦理和价值观的深刻拷问。

前瞻未来:迈向智能体的“万能”时代

展望未来,GPT模型的演进将不会止步。传闻中的GPT-5以及更遥远的未来,模型将继续在推理、逻辑和多模态融合上取得突破。我们将看到AI能够进行更复杂的科学研究、辅助设计更精妙的工程方案,甚至在创造性艺术领域展现出前所未有的才华。

然而,最令人兴奋的趋势莫过于AI智能体(Agents)的崛起。它们不再是简单的“聊天机器人”,而是能够自主规划、执行复杂任务的“数字员工”。想象一下,一个AI Agent可以帮你处理一整套复杂的项目,从前期调研、方案制定、与外部工具交互到最终成果的交付,所有这些都由AI独立完成。这预示着AI将从“问答机”进化为真正意义上的“执行者”,从辅助决策走向自主行动。

多模态的深度融合也将使AI与世界的互动更加自然。AI不仅能听懂你说的、看懂你画的,还能理解你的情绪、感知你的意图,并以最自然的方式与你交流。这为具身智能(Embodied AI)和机器人技术的发展铺平了道路,未来AI可能不再仅仅存在于屏幕中,而是真正走进我们的物理世界,成为我们生活和工作中不可或缺的智能伙伴。我们正站在一个激动人心的前沿,一个由AI智能体驱动的“万能”时代或许就在不远的将来。

您已阅读完《使用指南(共68篇)》专题的第 12 篇。请继续阅读该专题下面的文章:

- 13.GPT中转站与镜像站:两种接入方式的对比与选择指南

- 14.旗舰与平衡的选择:Claude 4 Opus 与 Claude 4 Sonnet 的比较分析

- 15.GPT-5:通往通用人工智能的史诗级飞跃与未来图景

- 16.如何在三步内快速接入 Google Gemini 3.0:一步API + Cherry Studio 解读

- 17.🔥 Claude Opus 4.5 国内无门槛接入指南:零代码调用编程天花板AI

- 18.免翻墙/国内直连调用Gemini3 保姆级教程

- 19.Google Gemini 3.0 Pro国内接入指南:API中转破解三重困境

- 20.Gemini CLI 调用 Gemini 3 Pro 完整教程:2025最新-已验证

- 21.国内AI开发者必看:Google Gemini 3.0 Pro无缝接入指南

- 22.国内开发者接入GPT – 5核心指南:突破痛点的API中转方案与实操教程

- 23.Claude Opus 4.5国内接入全攻略:突破三大壁垒,零成本解锁SOTA级AI能力

- 24.GPT-5 CLI 部署指南:YibuAPI 100万Token免费领,四模态调用零代码

- 25.PHP调用大模型API实战指南:从基础封装到生产部署

- 26.Claude Opus 4.5 API国内直连攻略:开发者零门槛接入指南

- 27.告别跨境壁垒!YibuAPI一键直连Claude Opus 4.5,国内开发者专属AI利器

- 28.低成本接入Gemini 3.0 Pro:GPT-5生态适配中转API方案

- 29.GPT-5.2重磅发布!YIBUAPI三步解锁,打工人告别无效加班

- 30.GPT-5.0与GPT-5.2深度评测及落地指南:性能跃迁解析与一步API实操手册

- 31.GPT服务第三方接入模式的比较研究:中转站与镜像站的技术架构、风险维度及选择范式

- 32.Go语言集成大模型API实战:从工程化封装到生产级落地

- 33.国内调用 GPT-5.2 API 完整教程(附Python代码)

- 34.gpt-image-1.5国内直连指南:API中转接入教程与技术优势 | 2025最新

- 35.step-audio-2引爆跨模态音频AI革命,国内落地全攻略

- 36.小米MiMo-V2-Flash:开源AI新纪元,效率与跨模能力的双重颠覆

- 37.GPT-Image-1.5 实测封神!碾压Nano Banana Pro的国内直连攻略

- 38.Mistral 3国内直连终极指南:API中转破解三大接入难题

- 39.gpt-image-1.5国内落地指南:突破壁垒,解锁多模态创作新可能

- 40.Claude Opus 4.5:登顶编程AI的核心逻辑与实操指南

- 41.Gemini 3.0 Pro:多模态编程AI的领军者,重塑人机协同开发新范式

- 42.Gemini 3.0 Pro:不止多模态,重新定义AI编程实用边界

- 43.GLM-4.7开源实测:358B参数大模型的平民化落地指南

- 44.DeepSeek-V3.2开源详解:340B混合专家模型,一步API打通工业级AI落地

- 45.中外AI大模型全景对比:国外顶尖模型高效接入指南(一步API方案)

- 46.AI大模型选型与落地指南:低门槛接入及全球格局深度解析

- 47.DeepSeek-V3.2与GPT-5.2优缺点全解析:一步API适配下的双模型对照

- 48.生态共振而非零和博弈:DeepSeek-V3.2与Gemini 3.0 Pro的AI产业赋能之路

- 49.GLM-4.7与GPT-5.2双模型评测:特性对比及一步API统一接入指南

- 50.Grok-4.1:不止于智能,xAI的人性化交互革命

- 51.Grok-4.1颠覆登场:双版本+双商赋能,改写大模型竞争规则

- 52.一步API:打通国内企业与全球顶尖AI的便捷桥梁

- 53.破解跨境AI接入难题:一步API赋能Gemini 3.0 Pro国内高效落地实战指南

- 54.Sora Video2商业落地指南:从功能赋能到API快速变现

- 55.Sora Video2 API进阶实战:避坑指南、性能优化与场景化落地方案

- 56.Sora Video2实战指南:从API接入到场景落地(附避坑与优化技巧)

- 57.深度实测 DeepSeek-V3.2:一步 API 解锁高效调用

- 58.Sora Video2新手入门:用一步API,5分钟生成第一条AI视频

- 59.Kimi K2.5+一步API开发实战:从接入到落地的全场景指南

- 60.Kimi K2.5深度解析:开源AI全能王者,一步API接入快速落地指南

- 61.ClaudeBox国内合规API接入实战手册:避坑指南+场景化落地方案

- 62.从开源工具到生产力革命:Clawdbot+一步API,解锁国内AI智能体新玩法

- 63.无代码玩转Clawdbot:一步API赋能本地AI,新手也能解锁自动化神器

- 64.从部署到落地:Clawdbot+一步API,打造专属本地AI自动化工作站

- 65.OpenClaw×一步API:本地AI智能体的企业级落地方案,从技术架构到场景实战

- 66.告别百人团队与数月工期!一步API让AI漫剧创作进入“轻量时代”

- 67.告别Sora2依赖!AI漫剧创作者必看:Veo 3.1实操指南与降本增效秘籍

- 68.告别模糊与崩脸!AI漫剧4K时代降临,一步API让创作效率翻倍