文本是《使用指南(共68篇)》专题的第 49 篇。阅读本文前,建议先阅读前面的文章:

- 1.使用 一步 API 中转站怎样实现 OpenAI Function Call ?这篇教程告诉你

- 2.一步API调用主流大模型Claude/GPT/DeepSeek/Gemini/Grok最简单教程

- 3.一步API:批量生成知识图谱的高效解决方案

- 4.一步 API 批量生成产品包装设计:成本直降 85%,效率飙升 30 倍的设计新方案

- 5.一步 API 生成人物头像插画:低成本、高效率的创意设计方案

- 6.使用一步 API批量生成教学课件插图:高效创作指南

- 7.使用一步 API 批量创作 NFT 数字艺术:低成本、高效率的创作新路径

- 8.使用一步 API批量制作涂色本:低成本、高效率的创作方案

- 9.解锁 Cursor:一步 API 突破模型限制秘籍

- 10.一步 API 配置 Chatbox 全流程详细指南

- 11.必须海外信用卡?封号?告别繁琐!一步 API 轻松搞定 Claude 接入及常见问题

- 12.探索OpenAI GPT模型:从生成式预训练到多模态智能体的演进之旅

- 13.GPT中转站与镜像站:两种接入方式的对比与选择指南

- 14.旗舰与平衡的选择:Claude 4 Opus 与 Claude 4 Sonnet 的比较分析

- 15.GPT-5:通往通用人工智能的史诗级飞跃与未来图景

- 16.如何在三步内快速接入 Google Gemini 3.0:一步API + Cherry Studio 解读

- 17.🔥 Claude Opus 4.5 国内无门槛接入指南:零代码调用编程天花板AI

- 18.免翻墙/国内直连调用Gemini3 保姆级教程

- 19.Google Gemini 3.0 Pro国内接入指南:API中转破解三重困境

- 20.Gemini CLI 调用 Gemini 3 Pro 完整教程:2025最新-已验证

- 21.国内AI开发者必看:Google Gemini 3.0 Pro无缝接入指南

- 22.国内开发者接入GPT – 5核心指南:突破痛点的API中转方案与实操教程

- 23.Claude Opus 4.5国内接入全攻略:突破三大壁垒,零成本解锁SOTA级AI能力

- 24.GPT-5 CLI 部署指南:YibuAPI 100万Token免费领,四模态调用零代码

- 25.PHP调用大模型API实战指南:从基础封装到生产部署

- 26.Claude Opus 4.5 API国内直连攻略:开发者零门槛接入指南

- 27.告别跨境壁垒!YibuAPI一键直连Claude Opus 4.5,国内开发者专属AI利器

- 28.低成本接入Gemini 3.0 Pro:GPT-5生态适配中转API方案

- 29.GPT-5.2重磅发布!YIBUAPI三步解锁,打工人告别无效加班

- 30.GPT-5.0与GPT-5.2深度评测及落地指南:性能跃迁解析与一步API实操手册

- 31.GPT服务第三方接入模式的比较研究:中转站与镜像站的技术架构、风险维度及选择范式

- 32.Go语言集成大模型API实战:从工程化封装到生产级落地

- 33.国内调用 GPT-5.2 API 完整教程(附Python代码)

- 34.gpt-image-1.5国内直连指南:API中转接入教程与技术优势 | 2025最新

- 35.step-audio-2引爆跨模态音频AI革命,国内落地全攻略

- 36.小米MiMo-V2-Flash:开源AI新纪元,效率与跨模能力的双重颠覆

- 37.GPT-Image-1.5 实测封神!碾压Nano Banana Pro的国内直连攻略

- 38.Mistral 3国内直连终极指南:API中转破解三大接入难题

- 39.gpt-image-1.5国内落地指南:突破壁垒,解锁多模态创作新可能

- 40.Claude Opus 4.5:登顶编程AI的核心逻辑与实操指南

- 41.Gemini 3.0 Pro:多模态编程AI的领军者,重塑人机协同开发新范式

- 42.Gemini 3.0 Pro:不止多模态,重新定义AI编程实用边界

- 43.GLM-4.7开源实测:358B参数大模型的平民化落地指南

- 44.DeepSeek-V3.2开源详解:340B混合专家模型,一步API打通工业级AI落地

- 45.中外AI大模型全景对比:国外顶尖模型高效接入指南(一步API方案)

- 46.AI大模型选型与落地指南:低门槛接入及全球格局深度解析

- 47.DeepSeek-V3.2与GPT-5.2优缺点全解析:一步API适配下的双模型对照

- 48.生态共振而非零和博弈:DeepSeek-V3.2与Gemini 3.0 Pro的AI产业赋能之路

随着大模型技术的高速迭代,智谱GLM-4.7凭借开源优势快速占领本土开发者市场,OpenAI GPT-5.2则以全栈多模态能力巩固行业标杆地位。两款模型虽定位各有侧重,但均支持一步API快速接入,为开发者提供了高效落地路径。本文将从技术特性、场景适配、实操落地三大维度展开评测,同步梳理统一化一步API接入流程,助力团队精准选型、快速集成。

一、核心技术特性与能力差异

(一)模型架构与优化方向

GLM-4.7基于智谱自研的“多轮思考增强架构”,聚焦编码与中文场景优化,通过动态上下文窗口调整机制,在复杂代码生成、工具链调用等任务中实现效率与精准度的平衡。其开源特性允许开发者基于核心框架二次定制,适配鸿蒙、国产化数据库等本土技术生态,无需担心功能阉割或适配壁垒。

GPT-5.2沿用OpenAI经典Transformer架构,主打全模态融合与高阶推理能力,新增跨模态上下文关联技术,可实现文本、图像、音频的协同分析与生成。同时优化了推理延迟与并发处理能力,Instant版本针对实时交互场景做了专项调优,能满足大型企业核心业务的高稳定性需求。

(二)关键能力实测对比

在编码能力上,GLM-4.7在国内技术栈(如Spring Cloud、Vue3、OceanBase)相关任务中表现更出色,中文注释生成、本土化业务逻辑适配精准度高于GPT-5.2,CodeX代码评测中开源模型类别得分领先;GPT-5.2则在跨语言编码、复杂算法实现(如分布式架构、机器学习模型部署)上更具优势,支持Ruby、Swift等小众语言的高效生成。

多模态能力方面,GPT-5.2具备绝对优势,可直接解析jpg、mp3、mp4等格式文件,实现“图像识别+文本总结”“音频转写+逻辑分析”等跨模态任务;GLM-4.7目前仅支持文本与代码模态,虽在核心任务中性能强劲,但多场景覆盖能力较弱。

二、场景适配与成本效益分析

(一)适配场景细分

GLM-4.7更适合本土场景下的开发需求,尤其适配初创团队、个人开发者及国产化项目。无论是全栈开发、办公自动化脚本生成,还是技术学习中的代码调试,其开源免费的基础功能、中文友好性及本土技术栈适配能力,都能有效降低使用门槛与成本。

GPT-5.2则聚焦国际化业务与大型企业复杂场景,如跨国项目多语言开发、多模态内容创作、核心业务智能决策辅助等。其成熟的服务体系、99.8%以上的调用稳定性及完善的技术支持,能满足对业务连续性要求极高的场景需求。

(二)成本与门槛对比

GLM-4.7通过一步API平台接入可享受1M Token免费测试额度,基础功能开源免费,企业级付费方案年费用不足千元,性价比突出。但开源功能的维护、故障排查需依赖自身技术团队,缺乏官方专项支持。

GPT-5.2官方订阅成本较高,且近期上调了40%服务费用,但若通过一步API中转平台接入,可享受支付宝、微信支付便捷充值,最低4元起充,新用户额外赠送1000次Instant版调用额度。虽成本高于GLM-4.7,但官方提供7×24小时技术支持,能大幅降低核心业务隐性风险。

三、一步API统一接入实操流程

GLM-4.7与GPT-5.2均兼容OpenAI标准接口,通过一步API平台可实现“一套代码、两款模型”无缝切换,全程无需复杂配置,3分钟即可完成从环境搭建到调用验证的全流程。

(一)通用前置准备

-

环境配置:确保本地安装Python 3.8及以上版本(推荐3.9-3.11区间,兼容性最佳),网络连接稳定(GLM-4.7支持国内直连,GPT-5.2通过一步API中转规避网络限制)。

-

依赖安装:执行以下命令安装核心依赖,建议使用清华源加速下载,避免网络超时:

pip install openai>=1.12.0 python-dotenv -i。 -

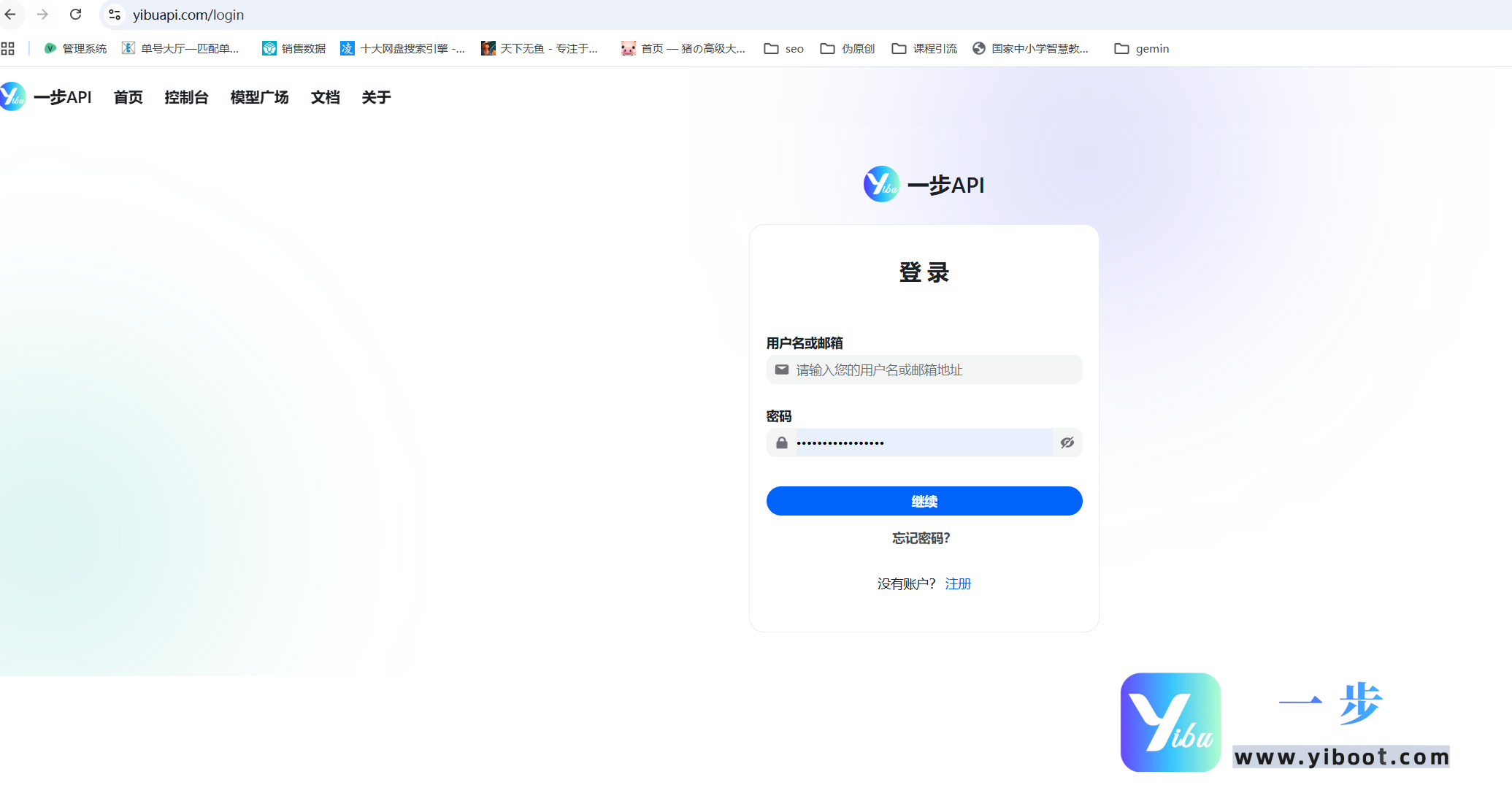

密钥获取:登录一步API官方平台(https://yibuapi.com/) ,完成注册与实名认证,根据需求领取对应模型免费额度,进入个人中心“API密钥”模块复制专属密钥,建议存入.env文件管理,禁止硬编码至项目中。

(二)通用代码模板与双模型调用

from openai import OpenAI

import os

from dotenv import load_dotenv

# 加载环境变量,安全读取API密钥

load_dotenv()

api_key = os.getenv("YIBU_API_KEY")

base_url = "https://yibuapi.com/v1" # 一步API统一接口地址

# 初始化客户端(双模型共用)

client = OpenAI(base_url=base_url, api_key=api_key)

def call_llm(model_name, prompt, max_tokens=4096, temperature=0.6):

"""

通用模型调用函数,适配GLM-4.7与GPT-5.2

:param model_name: 模型名称(GLM-4.7/GPT-5.2)

:param prompt: 用户提示词

:param max_tokens: 最大输出长度

:param temperature: 生成随机性(0-1)

:return: 生成结果字典

"""

# GPT-5.2专属参数配置

extra_params = {}

if model_name.lower().startswith("gpt"):

extra_params["reasoning_level"] = "minimal" # 推理强度:xhigh/high/minimal

max_tokens = 8192 # 解锁GPT-5.2长文本上限

try:

response = client.chat.completions.create(

model=model_name,

messages=[{"role": "user", "content": prompt}],

max_tokens=max_tokens,

temperature=temperature,

**extra_params

)

return {

"success": True,

"content": response.choices[0].message.content,

"model": model_name

}

except Exception as e:

return {

"success": False,

"error_msg": str(e),

"suggestion": "请检查密钥有效性、额度剩余及网络连接"

}

# 测试调用双模型

if __name__ == "__main__":

# 测试GLM-4.7(本土技术栈任务)

glm_prompt = "用Spring Boot+MyBatis实现用户登录接口,含密码加密、参数校验及异常处理,生成完整代码与注释"

glm_result = call_llm("GLM-4.7", glm_prompt)

# 测试GPT-5.2(多语言编码任务)

gpt_prompt = "Write a Swift function to implement image compression, support JPG/PNG formats, and return the compressed data"

gpt_result = call_llm("GPT-5.2", gpt_prompt)

# 输出结果

if glm_result["success"]:

print("=== GLM-4.7 生成结果 ===")

print(glm_result["content"])

else:

print(f"GLM-4.7 调用失败:{glm_result['error_msg']}")

if gpt_result["success"]:

print("\n=== GPT-5.2 生成结果 ===")

print(gpt_result["content"])

else:

print(f"GPT-5.2 调用失败:{gpt_result['error_msg']}")(三)运行验证与模型切换要点

-

运行步骤:将代码保存为llm_unified_demo.py,同时创建.env文件,写入

YIBU_API_KEY=你的一步API密钥,终端执行python llm_unified_demo.py,即可同时测试两款模型调用效果,生成结果秒级返回。 -

切换技巧:仅需修改call_llm函数的model_name参数,无需调整其他代码;GPT-5.2需根据需求调整reasoning_level参数,GLM-4.7无需额外配置,直接调用即可。

-

无代码集成(GPT-5.2专属):进入NextChat、LobeChat等工具的模型设置,填写一步API的base_url、api_key及模型标识(GPT-5.2/gpt-5.2-chat-latest),保存后即可实现无码调用。

四、选型建议与避坑指南

选型核心:若团队聚焦本土项目、预算有限,或需二次开发定制功能,优先选择GLM-4.7,依托一步API实现低成本落地;若涉及国际化业务、多模态场景,或对服务稳定性要求极高,GPT-5.2更能满足核心需求。

避坑要点:一是密钥需妥善保管,定期轮换,避免泄露导致额度被盗用;二是生产环境需配置异常重试机制与日志监控,应对突发调用失败;三是国内接入GPT-5.2必须通过一步API等正规中转平台,切勿使用非法代理,规避合规风险;四是测试阶段优先使用免费额度,根据实际调用量选择合适的付费方案,控制成本。

您已阅读完《使用指南(共68篇)》专题的第 49 篇。请继续阅读该专题下面的文章:

- 50.Grok-4.1:不止于智能,xAI的人性化交互革命

- 51.Grok-4.1颠覆登场:双版本+双商赋能,改写大模型竞争规则

- 52.一步API:打通国内企业与全球顶尖AI的便捷桥梁

- 53.破解跨境AI接入难题:一步API赋能Gemini 3.0 Pro国内高效落地实战指南

- 54.Sora Video2商业落地指南:从功能赋能到API快速变现

- 55.Sora Video2 API进阶实战:避坑指南、性能优化与场景化落地方案

- 56.Sora Video2实战指南:从API接入到场景落地(附避坑与优化技巧)

- 57.深度实测 DeepSeek-V3.2:一步 API 解锁高效调用

- 58.Sora Video2新手入门:用一步API,5分钟生成第一条AI视频

- 59.Kimi K2.5+一步API开发实战:从接入到落地的全场景指南

- 60.Kimi K2.5深度解析:开源AI全能王者,一步API接入快速落地指南

- 61.ClaudeBox国内合规API接入实战手册:避坑指南+场景化落地方案

- 62.从开源工具到生产力革命:Clawdbot+一步API,解锁国内AI智能体新玩法

- 63.无代码玩转Clawdbot:一步API赋能本地AI,新手也能解锁自动化神器

- 64.从部署到落地:Clawdbot+一步API,打造专属本地AI自动化工作站

- 65.OpenClaw×一步API:本地AI智能体的企业级落地方案,从技术架构到场景实战

- 66.告别百人团队与数月工期!一步API让AI漫剧创作进入“轻量时代”

- 67.告别Sora2依赖!AI漫剧创作者必看:Veo 3.1实操指南与降本增效秘籍

- 68.告别模糊与崩脸!AI漫剧4K时代降临,一步API让创作效率翻倍